Wenn das Internet nicht richtig funktionieren würde, wären keine Bankgeschäfte möglich! Dieses Argument wird gern gegen Klangunterschiede bei der digitalen Musikwiedergabe ins Feld geführt. Und in der Tat gibt es Sicherheitsmechanismen, die sehr zuverlässig dafür sorgen, dass der digitale Code richtig beim Empfänger ankommt. Trotzdem sind zum Teil deutliche klangliche Einschränkungen bei digitaler Audioübertragung möglich. Wir wollen uns dem Thema zuerst auf der digitalen Ebene und dann auf der analogen Ebene nähern.

Die digitale Ebene

Die digitale Speicherung und der Transport von Musik erfolgt in Form von Bytes, welche aus 8 Bits bestehen. Ein Bit kann zwei mögliche Zustände annehmen, die meist als „Null“ und „Eins“ bezeichnet werden. Natürlich soll das Audiosignal bitidentisch transportiert werden. Damit das gelingt sehen wir uns die Prüfsummenprotokolle im Internet an.

Prüfsummen

Mit dem IEEE 802.3 Tagged MAC Frame wird das gängige Format der Ethernet-Datenübertragungsblöcke beschrieben. Wichtig ist hier der Abschnitt für die CRC-Prüfsummen, siehe unten im Bild der rechte Datenblock. Wenn ein Paket beim Sender erstellt wird, erfolgt eine CRC-Berechnung über die Bitfolge und die Prüfsumme wird an den Datenblock angehängt. Der Empfänger führt nach dem Empfang die gleiche Berechnung aus. Stimmt die empfangene nicht mit der selbst berechneten Prüfsumme überein, geht der Empfänger von einer fehlerhaften Übertragung aus und der Datenblock wird verworfen und neu angefordert.

Das ist auch das Standardargument derjenigen, die sich über Ethernetoptimierungen lustig machen. Die Daten kommen immer Bitperfekt an. Musik ist jedoch zeitkritisch. Wenn die Zeit bei einem fehlerhaften Paket für eine Wiederholung nicht mehr ausreicht, ist zum Beispiel das typische Knistern wie bei einer Schallplatte zu hören. Bei gravierenden Übertragungsproblemen kommt es zu Dropouts.

Samplingraten und Puffer bestimmen die Latenzen

Ein Sample ist die kleinste Einheit bei der Audio-Abtastung. Bei 44,1 kHz (CD-Format) sind es z.B. 44.100 Samples pro Sekunde. Daraus lässt sich die Latenz errechnen. Latenz bedeutet zeitliche Verzögerung zwischen Aktion und Reaktion. Störende Latenzen liegen im Datenstrom und in der Datenverarbeitung begründet. Beim Rendern von Audiosignalen (z. B. von Flac in PCM oder DSD) und der Übertragung dieser Daten entstehen Latenzen. Sie ergeben sich aus der von der Soft- und Hardware benötigten Zeit, die Daten zu verarbeiten. Bei der Datenübertragung spielen zudem der Sample-Puffer (engl. Buffer) eine Rolle, die bei Audiokarten üblicherweise im Bereich zwischen 52 und 512 Samples liegen, um ein Abreißen des Datenstroms zu verhindern.

Latenzen bei einem CD-Format mit Standardpuffereinstellung:

44.100 Samples = 1.000 ms

256 Samples = 5,8 ms (1000*256/44.100)

Die 256 Samples stellen in den USB oder Ethernet-Treibern den sogenannten Puffer dar. Nach 5,8 ms erfolgt ein Interrupt und der Speicherinhalt wird gesendet und geleert. Nun steht der Puffer für weitere 256 Samples bereit. Je größer der Puffer ist, desto größer sind die Latenzen. Dafür wird die CPU weniger belastet. Umgekehrt führt ein sehr geringer Puffer zu sehr geringen Latenzen. Jedoch wird die CPU mehr belastet, da die Interrupts häufiger vorkommen.

Beispiel für sehr geringe Latenzen:

44.100 Samples = 1.000 ms

52 Samples = 1,18 ms (1000*52/44.100)

Durch die Verringerung der Samples können die Latenzen deutlich reduziert werden. Die Pakete sind kleiner und müssen häufiger versendet werden.

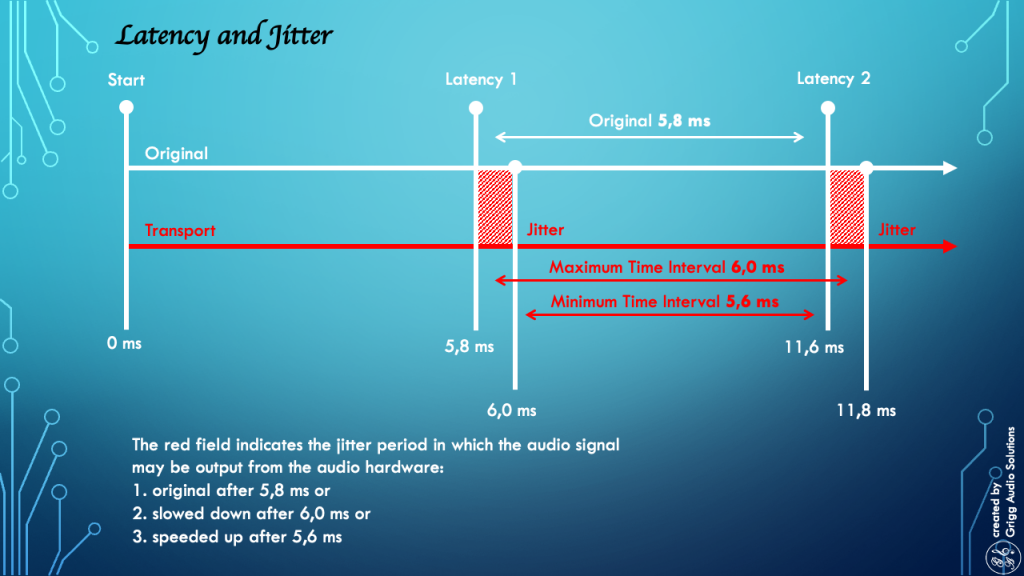

Latenzen und Jitter

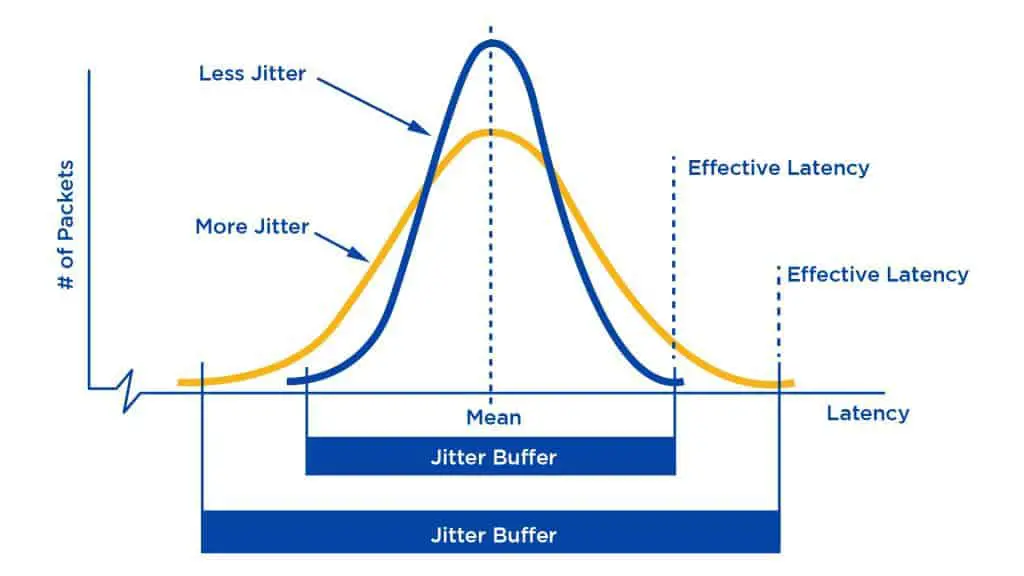

Während die Latenz eine feste Zeit zwischen zwei Ereignissen definiert, beschreibt Jitter die Schwankungen innerhalb dieser Zeit. Im Bild unten wird das Audio Signal in Paketen versendet, welches im Originalzustand alle 5,8 ms ein Paket mit 256 Samples transportiert. Jitter kann dazu führen, dass die Samples unten im Beispiel auf bis zu 6,0 ms verlangsamt oder auf bis zu 5,6 ms beschleunigt werden. Wird die Taktung nicht korrigiert ist das hörbar.

Nun lassen sich die Auswirkungen von Jitter vermindern, wenn die Latenzen durch einen geringeren Puffer verringert werden. Bei einer 44.1 kHz Audiodatei kann zum Beispiel der Puffer auf 52 Samples reduziert werden. Dies führt wie oben im Rechenbeispiel zu einer sehr geringen Latenz von 1,18 ms. Im Bild unten wird der Zusammenhang zwischen kleinem Puffer, dafür mehr Pakete und weniger Jitter (blaue Kurve) deutlich. Aber Vorsicht! Die Hardware und Software müssen dafür geeignet sein, sonst führen die häufigen Interrupts zu einer Überlastung des Systems und der Datenstrom reißt ab.

Die Gegenstimmen argumentieren, dass Jitter bei der Datenübertragung keine Rolle spielt, da letztendlich im DAC sowieso alles in dessen Puffer landet und bei asynchroner Datenübertragung von dort aus neu getaktet wird. Rein technisch ist das richtig. Viele Beobachtungen deuten jedoch darauf hin, dass ein zeitlich perfekt transportiertes Signal (zum Beispiel durch Reclocking) einen hörbaren positiven Effekt hat. Mittlerweile gibt es eine Theorie dazu: der niederfrequente Jitter (Wander) ist der Schlüssel. Siehe hierzu: Neue Thesen zum Reclocking.

Digital Analog Converter (DAC)

Am Ende muss aus dem digitalen Signal wieder die analoge Amplitude gewonnen werden. Beim CD-Format wird die Amplitude 44.100fach pro Sekunde (44.1 kHz) abgetastet. Die Bandbreite ist dabei auf die Hälfte, nämlich auf 22.05 kHz beschränkt. Grundlage ist das Nyquist-Shannon-Abtasttheorem. Dabei wird das Originalsignal mit einer Rate abgetastet, die mehr als doppelt so hoch wie die höchste im Signal vorkommende Frequenz ist. Wird das Abtasttheorem durch eine zu niedrige Abtastrate verletzt, so werden Frequenzanteile, die ursprünglich höher waren als die halbe Abtastrate (Nyquist-Frequenz), als niedrigere Frequenzen interpretiert, da für diese eine Unterabtastung stattfindet. Dieses unerwünschte Phänomen wird Alias-Effekt genannt.

Dafür gibt es Anti-Aliasing Filter (Tiefpassfilter), die bei einer 44.1 kHz Quelle sehr steil ausfallen müssen. Idealerweise sehen wir alles bis 20 kHz ohne Dämpfung und dann vollständig bis 22,05 kHz gedämpft. Die Filter 5 und 7 unten im Bild zeigen noch die beste Dämpfung. Der Default Filter dämpft jedoch bereits im hörbaren Frequenzbereich, die Filter 2 und 4 dämpfen erst vollständig ab 28 kHz und lassen somit bei 44.1 Quellen Alias-Effekte zu.

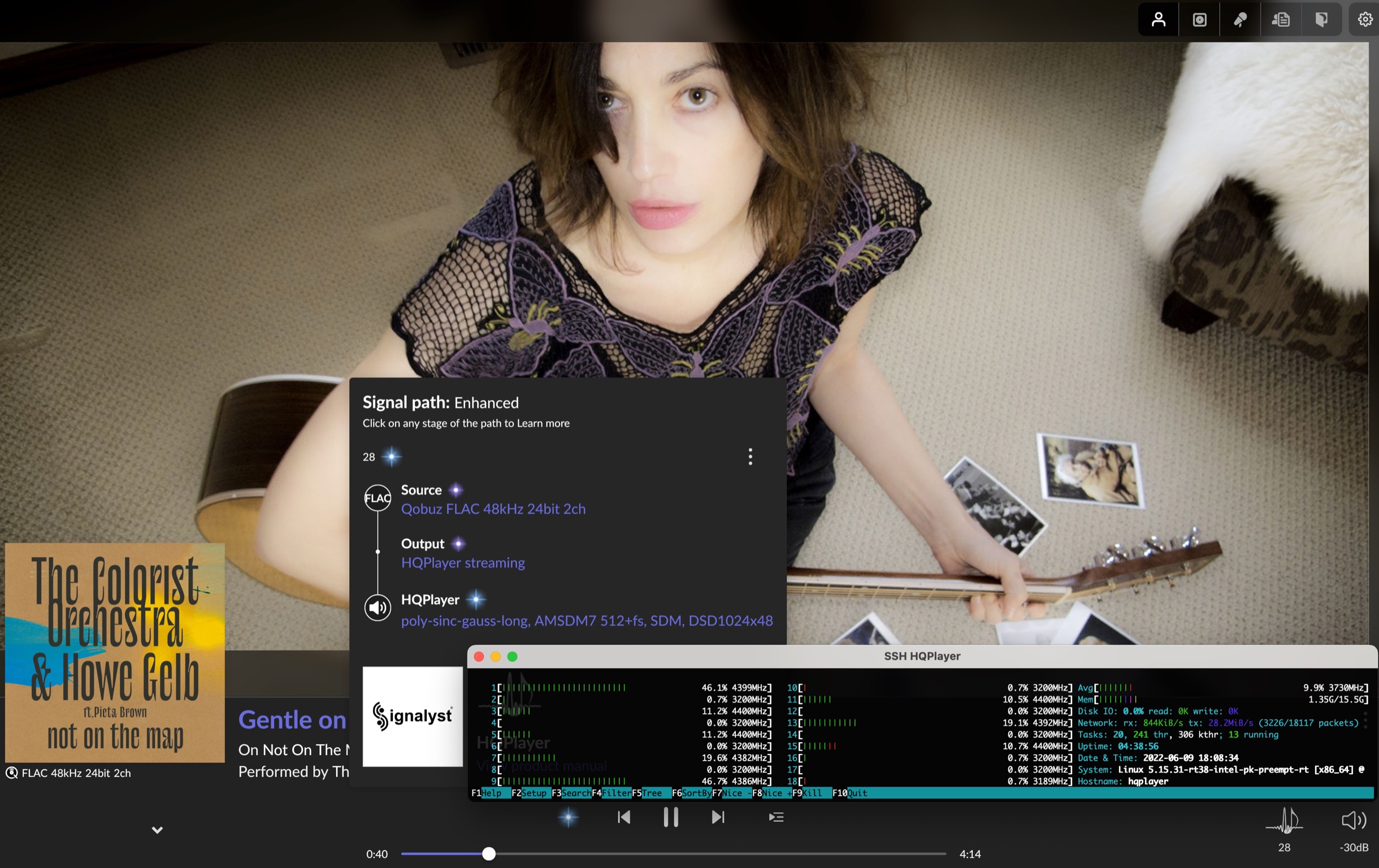

Deshalb kann HiRes ab 88.2 kHz einen hörbaren Vorteil haben, da hier der Anti-Aliasing-Filter erst später einsetzen und weniger steil dämpfen muss und somit den hörbaren Bereich nicht tangiert. Alternativ werden im Audio PC hochwertige Filter eingesetzt, wie zum Beispiel im HQPlayer. Wenn der DAC in den NOS (Non Oversampling) Modus versetzt wird, werden die internen Filter umgangen und die höherwertigeren Filter verwendet. Dies setzt eine angemessene Rechenleistung des Audio PCs voraus.

Die analoge Ebene

Wir sehen uns jetzt die analoge Ebene für die digitale Audioübertragung an. Denn die Bits werden in Hochfrequenz nach dem Prinzip der differentiellen Signalübertragung mit symmetrischen Spannungen übertragen!

Hochfrequenz (HF)

Für die Übertragung gibt es verschiedene Frequenzbereiche. Ein Cat5-Kabel überträgt die Daten mit einer Frequenz von bis zu 100MHz und schafft damit maximal eine Rate von 100Mbps. Ein CAT6a-Kabel überträgt bis 500MHz mit einem maximalen Durchsatz von 10Gbps. Hochfrequenzanteile können sich sehr parasitär in angeschlossenen Geräten einnisten und das Nutzsignal demodulieren. Wer zum Beispiel mit dem Smartphone in die Nähe eines Röhrenverstärkers kommt, wird die Funksignale im GHz-Bereich hören.

| Kategorie | Netzwerk | Übertragungsfrequenz | Maximale Übertragungsrate | Übertragungsdistanz |

|---|---|---|---|---|

| Cat5 | 100Base-T & 10Base-T | 1~100MHz | 100Mbps | 100m |

| Cat5e | 1000Bsae-T | 1~100MHz | 1000Mbps | 100m |

| Cat6 | 1000Bsae-T | 1~250MHz | 1000Mbps/10Gbps | 100m/37~55m |

| Cat6a | 10GBase-T | 1~500MHz | 10Gbps | 100m |

| Cat7 | 10GBase-T | 1~600MHz | 10Gbps | 100m |

| Cat8 | 25/40GBase-T | 1~2000MHz | 25Gbps oder 40Gbps | 2000 MHz bei 30m |

Eye pattern Diagramm

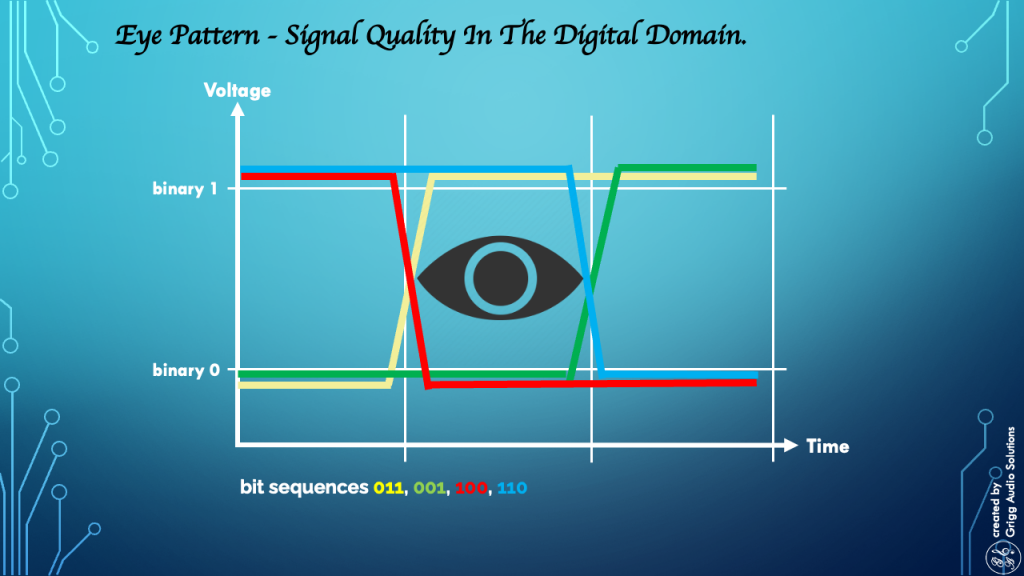

Das Eye pattern oder Augenmusterdiagramm lässt Rückschlüsse auf die Qualität des Signals zu. Dabei wird über einen Oszilloskop die Überlagerung aufeinanderfolgender Wellenformen zu einem zusammengesetzten Bild erstellt. Im Bild unten wird auf der Ordinate (y-Achse vertikal) der Spannungszustand definiert, ab der eine binäre 0 oder 1 anliegt. Auf der Abszisse (x-Achse horizontal) ist der Zeitverlauf angegeben. Über die Spannungszustände und dem Zeitverlauf ergibt sich so zum Beispiel eine Bitsequenz von 011 (Gelb).

Wenn sich über die verschiedenen Bitsequenzen auf dem Oszilloskop in der Mitte ein großes Auge erkennen lässt, ist die Signalqualität in Ordnung. Störungen in den Spannungsverläufen, zum Beispiel Verschiebungen durch Jitter oder eine zu geringe Steilheit in den Flanken können zu Fehlinterpretationen der Bitsequenzen führen. Durch die Prüfsummen wird das fehlerhafte Datenpaket zwar erkannt, aber wenn das zu oft passiert gehen Datenpakete verloren.

Daraus folgt die Erkenntnis, dass es auch auf eine gute Qualität der Kabel ankommt! Neben der reinen Dämpfung des Leiters und der Qualität der Steckverbindungen machen sich andere Effekte wie z. B. Übersprechen, Leitungskapazitäten und -induktivitäten, Störstrahlung von außen und bei sehr hohen Frequenzen sogar der Skin-Effekt bemerkbar. Bewährt haben sich zum Beispiel LAN Kabel mit nicht aufgelegtem Schirm oder RJ45-Stecker aus Kunststoff mit dem gleichen Effekt. So werden Masseschleifen vermieden. Alternativ kann mit Glasfaser (Lichtwellenleiter – LWL) eine perfekte galvanische Trennung erreicht werden. WLAN wird auch von vielen genutzt, ist jedoch störanfällig und wirkt mit den WLAN Antennen in der Nähe der Anlage als HF-Schleuder.

Gleichtaktstörungen

Unter Gleichtaktstörungen werden Störspannungen und -ströme auf den Verbindungsleitungen zwischen elektrischen Komponenten oder elektrischen Bauelementen verstanden, welche sich mit gleicher Phasenlage und Stromrichtung sowohl auf der Hinleitung als auch der Rückleitung zwischen diesen Komponenten ausbreiten. Es hat sich gezeigt, dass Switche und Router von einer Stromversorgung mit geringem Ripple Noise profitieren.

Zusammenfassung

Auf der digitalen Ebene wird über Prüfsummen sichergestellt, dass die Audiodaten bitidentisch beim Empfänger ankommen. Wenn die Zeit für eine erneute Anforderung und Verarbeitung eines Datenpakets jedoch nicht mehr ausreicht, dann gehen Datenpakete mit klanglichen Auswirkungen verloren.

In den Schnittstellen für Ethernet, WLAN und USB können in der Regel die Puffer über die Samplingraten erhöht oder verringert werden. Mit einer Verringerung der Samplingraten werden die Latenzen kleiner und Jitter kann dadurch reduziert werden. Dies setzt jedoch leistungsfähige Komponenten voraus, da die CPU stärker gefordert wird.

In der digitalen Signalverarbeitung müssen Anti-Aliasing-Filter eingesetzt werden. Diese können bei schlechter Qualität das hörbare Frequenzspektrum beeinflussen. Lösungen sind „echte“ HiRes -Dateien und/oder leistungsfähige Audio PCs mit entsprechender Software. Der DAC läuft dann im NOS.

Der Transport der Bits erfolgt analog über Hochfrequenz (HF) nach dem Prinzip der differentiellen Signalübertragung mit symmetrischen Spannungen. Selbst wenn alles bitidentisch übertragen wurde, kann sich Hochfrequenz parasitär im DAC und anderen Geräten breit machen und das hörbare Spektrum demodulieren.

Die Signalintegrität der unterschiedlichen Spannungszustände ist wichtig. Fällt das Eye pattern Diagramm schlecht aus, können die Bitsequenzen nicht mehr zuverlässig unterschieden werden und die Datenpakete werden verworfen. Gute LAN Kabel sind deshalb wichtig oder es werden alternativ Lichtwellenleiter (LWL) verwendet. Gleichtaktstörungen können durch gute (lineare) Netzteile mit geringem Ripple Noise reduziert werden.

Mehr davon? Dann melde dich bei unserem Newsletter an.