Einleitung

USB wird von vielen Audiogeräten für die digitale Signalübertragung verwendet. Die Vorteile liegen in der weiten Verbreitung, hohen Standardisierung und der großen Bandbreite, die problemlos PCM1536 und DSD1024 transportieren kann.

Die Nachteile liegen im Paketrauschen, sowie Netzteilrauschen, Erdschleifen und auch in der Mitführung von Stromadern mit 5V DC (Gleichstrom). Störungen können sich im empfindlichen DAC einnisten und dort den analogen Signalpfad demodulieren.

In den Grundlagen sehen wir uns USB in der Theorie an und beleuchten den USB 3.0 SuperSpeed-Isolator 7055-C von Intona im Test.

Grundlagen

USB (Universal Serial Bus)

Der Universal Serial Bus (USB) ist ein Industriestandard von 1996, der vom USB Implementers Forum (USB-IF) entwickelt wurde und den Datenaustausch und die Stromversorgung zwischen vielen Arten von elektronischen Geräten ermöglicht. USB-Anschlüsse werden in unserem Kontext verwendet, um Audioinformationen zwischen Computern, digitalen Audiogeräten und Peripheriegeräten zu übertragen. Ein USB-Anschluss kann dazu verwendet werden, digitale Audiosignale von einem Computer an externe USB-DACs (Digital-Analog-Wandler) oder andere Audiogeräte zu senden.

Isochrone Audiodatenübertragung

Der isochrone Transfer wird zum Beispiel von der USB-Audio-Class benutzt, die bei externen USB-Soundkarten Verwendung findet. Der Unterschied zur asynchronen Übertragung liegt in einem Signal mit konstanten Intervallen. USB sendet Datenpakete in einem Intervall von 125 Mikrosekunden, was einer Übertragungsrate von 8 kHz entspricht. Der zeitliche Abstand zwischen zwei übertragenen Frames ist stets gleich groß. Hierbei bestimmt der DAC die Taktrate und fordert Daten vom Quellgerät an.

Die erforderliche Datenrate ergibt sich aus dem Produkt des Abfrageintervalls und der Größe des Datenpuffers. Hi-Speed-Geräte können bis zu drei Übertragungen je Micro-Frame (125 µs) mit bis zu 1024 Byte ausführen (24.576 kB/s). USB 2.0 bietet eine maximale theoretische Bandbreite von 480 Mbit/s. Die Abtastraten können je nach DAC (Digital-Analog-Wandler) bis zu PCM1536 und DSD1024 gehen.

Bei USB ist die Übertragung mit einer CRC-Prüfsumme gesichert, wird aber bei einem Übertragungsfehler durch die Hardware nicht wiederholt. Daher kommt es bei fehlerhaften Datenübertragungen zum Knistern wie von einer Schallplatte.

Elektrische Spezifikation

USB-Signale werden über eine differentielle Signalisierung auf einem Twisted-Pair-Datenkabel mit einer charakteristischen Impedanz von 90 Ω ± 15 % übertragen. Der High-Speed-Modus (USB 2.0) verwendet ein einzelnes Datenpaar mit den Bezeichnungen D+ und D− im Halbduplex-Modus. Die Signalspannungen betragen von -10 bis 10 mV für niedrige und 360 bis 440 mV für logisch hohen Pegel, um die logische 0 oder 1 elektrisch abbilden zu können.

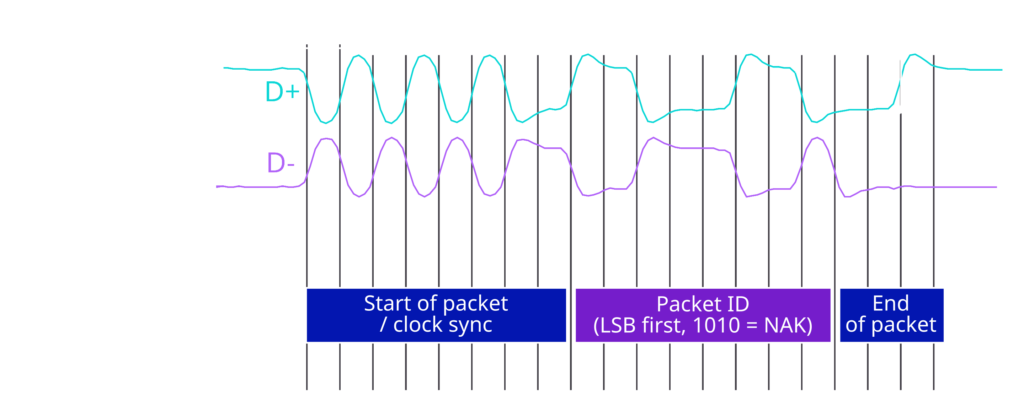

Im Beispiel unten ist eine Darstellung des USB-Signals (USB 1.1) auf der elektrischen Ebene. Hier liegen die übertragenen Signalpegel bei 0,0 bis 0,3 V für den logischen Tiefpegel und 2,8 bis 3,6 V für den logischen Hochpegel. Es besteht aus den folgenden Feldern: Das Clock Synchronization Byte für die Taktgenerierung, den Typ des Pakets und das Ende des Pakets. Datenpakete enthalten mehr Informationen zwischen dem Typ des Pakets und dem Ende des Pakets, aber das Prinzip lässt sich hier gut darstellen.

USB kodiert Daten mit der NRZI-Zeilencodierung:

- 0 Bit wird übertragen, indem die Datenleitungen von J nach K oder umgekehrt umgeschaltet werden.

- 1 Bit wird übertragen, indem die Datenleitungen unverändert bleiben.

Probleme bei USB Datenübertragungen

In der weiteren Betrachtung halten wir fest, dass die Bits über unterschiedliche Spannungszustände elektrisch übertragen werden und daher der Signalweg, wie jeder elektrische Leitungsdurchfluss, dem Rauschen ausgesetzt sind. Elektrisches Rauschen kann die Signalintegrität beeinträchtigen. Bei Störungen kann der USB Controller eventuell nicht mehr zuverlässig zwischen Bit0 und Bit1 unterscheiden. Die Länge von USB-Kabel ist deshalb beschränkt und soll zum Beispiel bei USB 2.0 die 5m nicht überschreiten. Das Rauschen überträgt sich auch auf die angeschlossenen Geräte und kann diese kontaminieren.

Wenn Signalverluste auftreten, macht sich das meist über Knistern wie bei einer Schallplatte bemerkbar. Bei gravierenden Problemen kommt es zu Dropouts.

Das Rauschen und Erdschleifen können sich auch im angeschlossenen Gerät negativ bemerkbar machen.

Test Intona USB 3.0 SuperSpeed-Isolator 7055-C

Die deutsche Firma Intona Technology GmbH ist ein Spezialist für USB-Isolatoren und seit fast zwei Jahrzehnten unter anderem für die Medizintechnik und Luftfahrtindustrie tätig, die extrem störungsunempfindliche Verbindungen benötigen.

Technische Merkmale

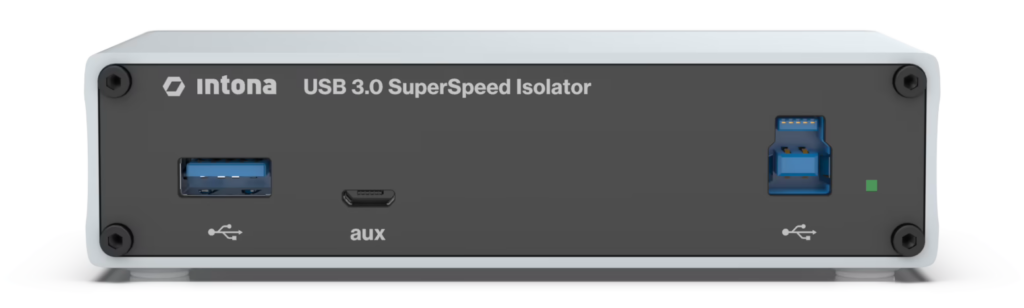

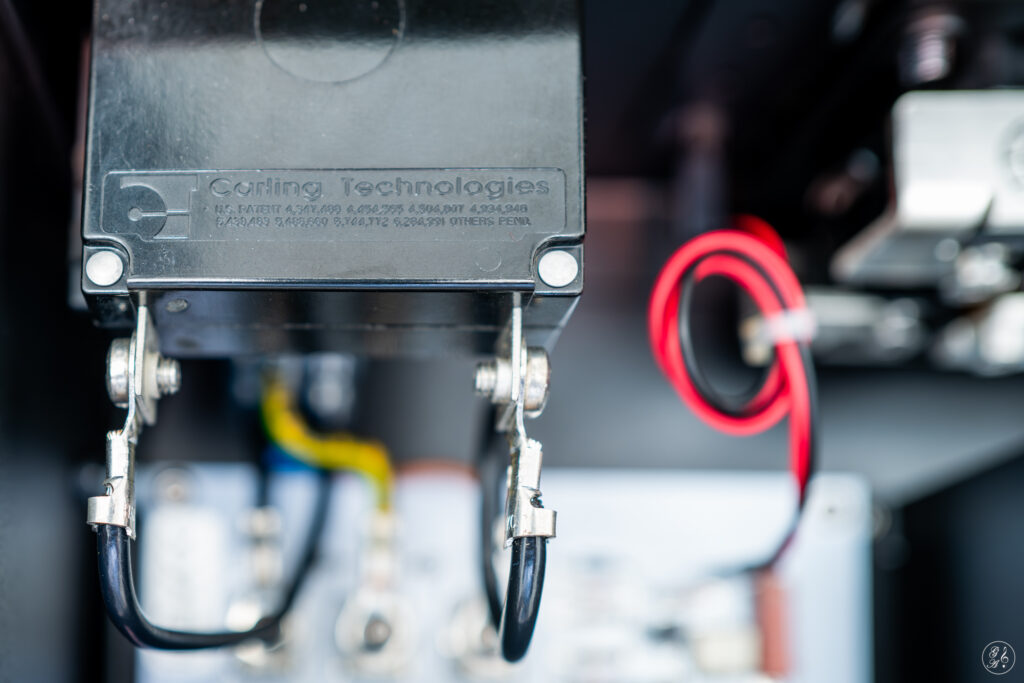

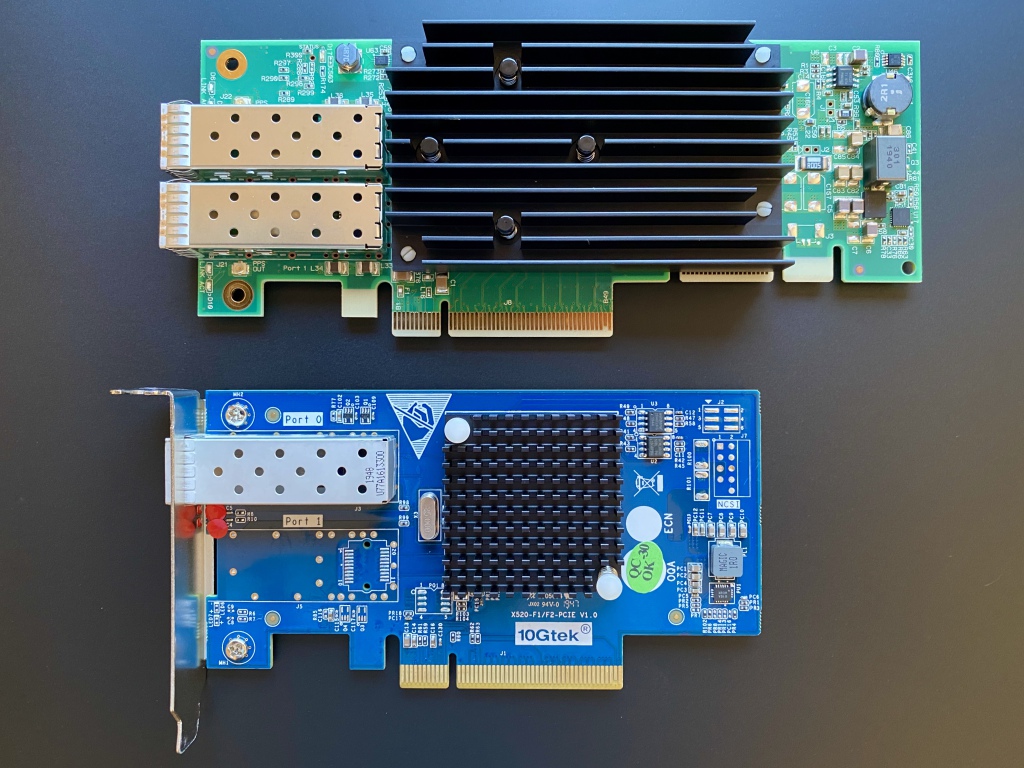

Der USB 3.0 SuperSpeed-Isolator 7055-C von Intona hat eine rein analog gestaltete USB 3.0-Isolation und wurde für Audio- und Videoanwendungen entwickelt. Im Bild unten geht es rechts mit einem USB 3.x B-Typ-Anschluss in den Isolator rein und links geht es per USB 2.0 Hi-Speed Kabel galvanisch isoliert wieder raus.

Generell benötigt der Isolator keine separate Stromversorgung, sondern wird über USB mit 5V versorgt. Die galvanisch isolierte Seite kann über eine externe Stromversorgung mit bis zu 2000mA für energiehungrige Geräte per Micro-USB (aux) mit Strom versorgt werden. Ansonsten stellt der USB 2.0 Ausgang die 5V mit 900mA zur Verfügung. Wenn ein externes Netzteil über „aux“ angeschlossen wird, schaltet der Isolator automatisch auf diese Stromversorgung um.

Der Isolator verhält sich für Host und Gerät transparent, das heißt es wird nicht als zusätzliches Gerät wahrgenommen und es werden keine Treiber benötigt. Es gibt keine Bandbreitenbeschränkung, so dass uneingeschränkt die USB-Spezifikationen gelten. Die Kontakte der Anschlussterminals sind mit Gold beschichtet.

Technische Merkmale vom Hersteller (Auswahl):

- Output Noise RMS measured: 20kHz = 0.9μV | 80kHz = 1.6μV | 500kHz = 8.5μV

- Powered by USB host device; internal DC/DC converter for isolated side

- Gehäuse: 120 x 30 x 70 mm

- Gewicht: 300 g

Das folgende Bild zeigt, wie klein der Isolator ist. Dieser steht auf den ohnehin nicht großen DAC 200 von T+A.

Messungen

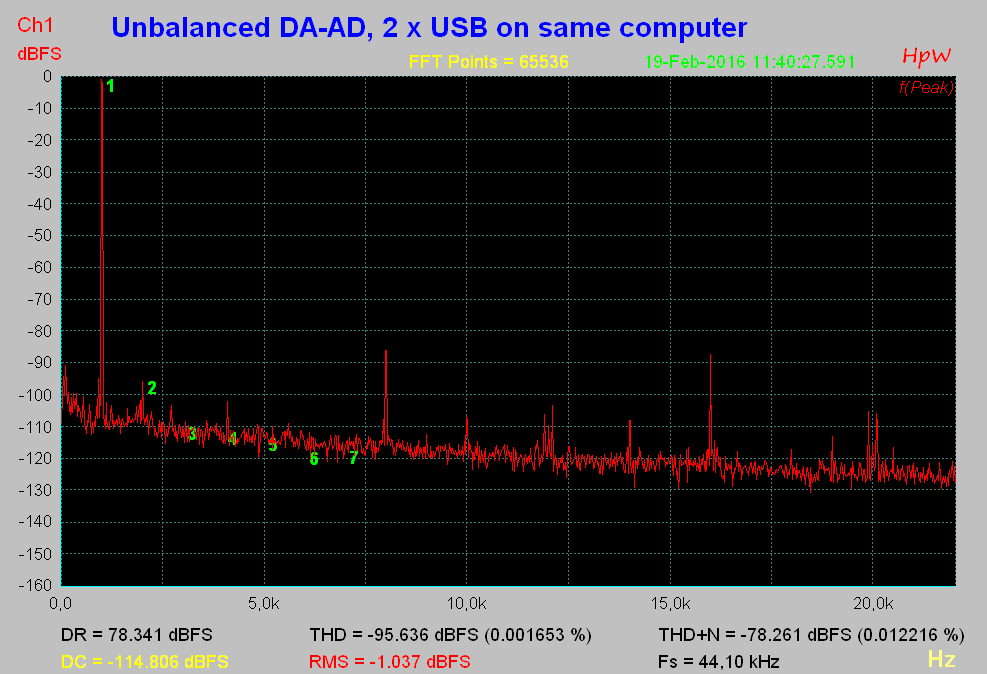

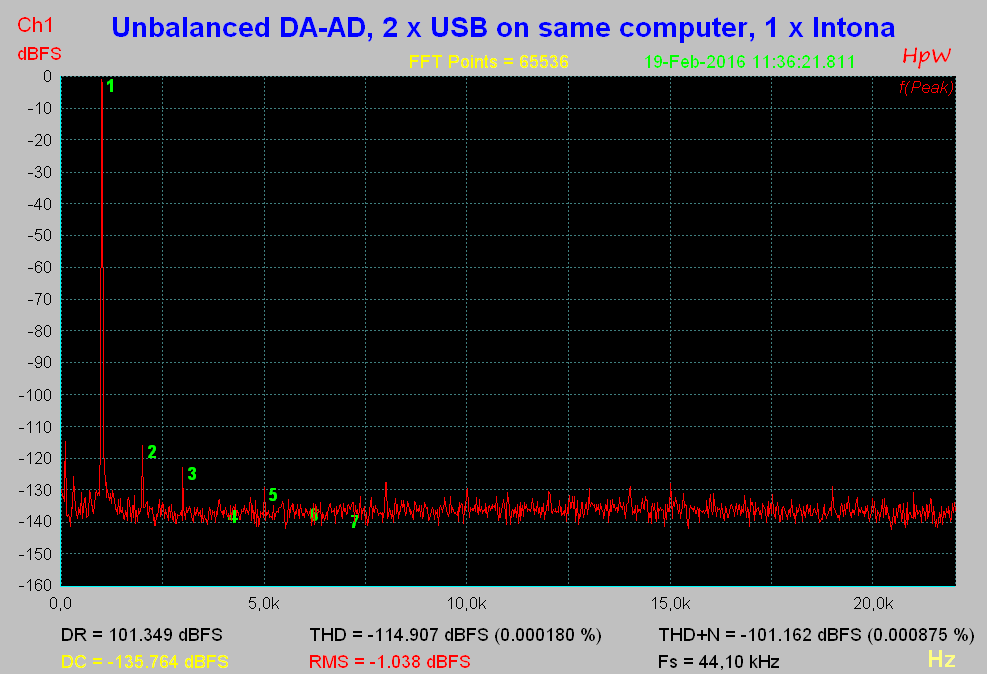

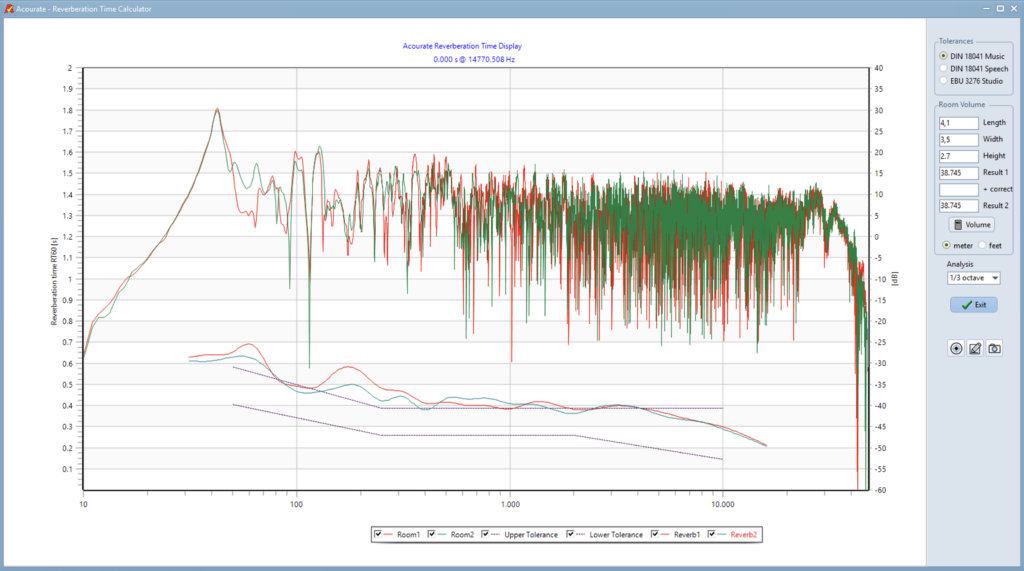

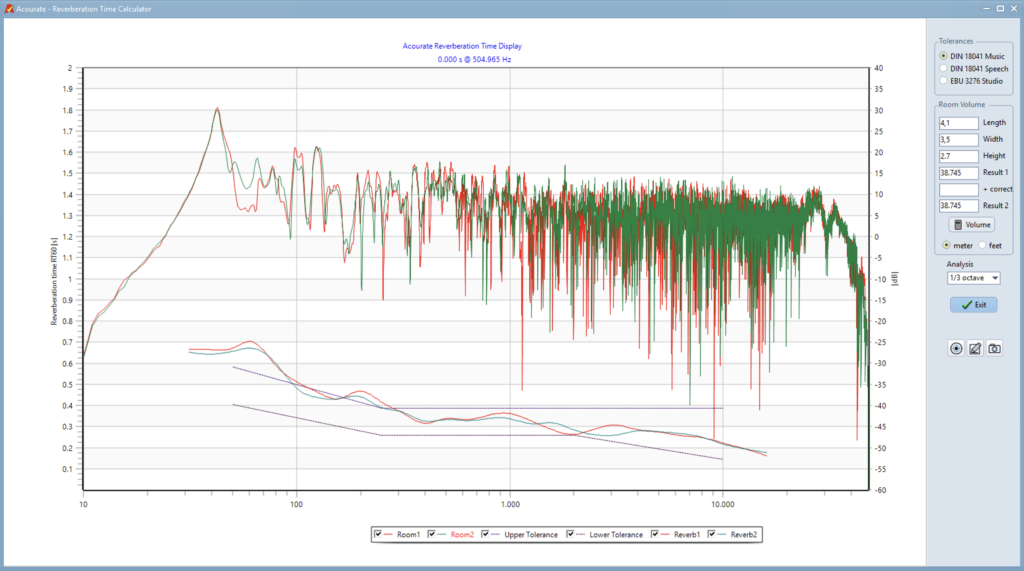

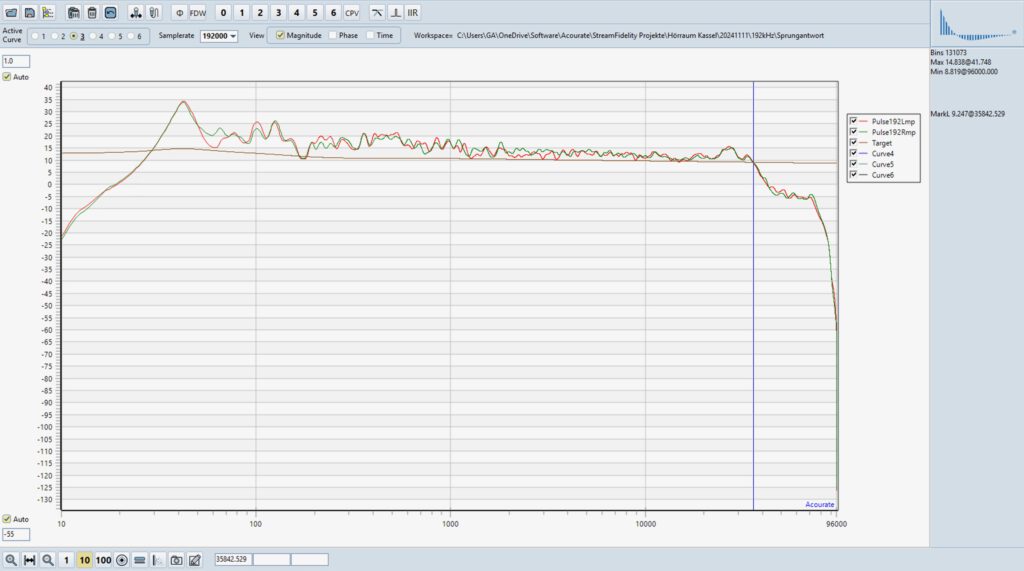

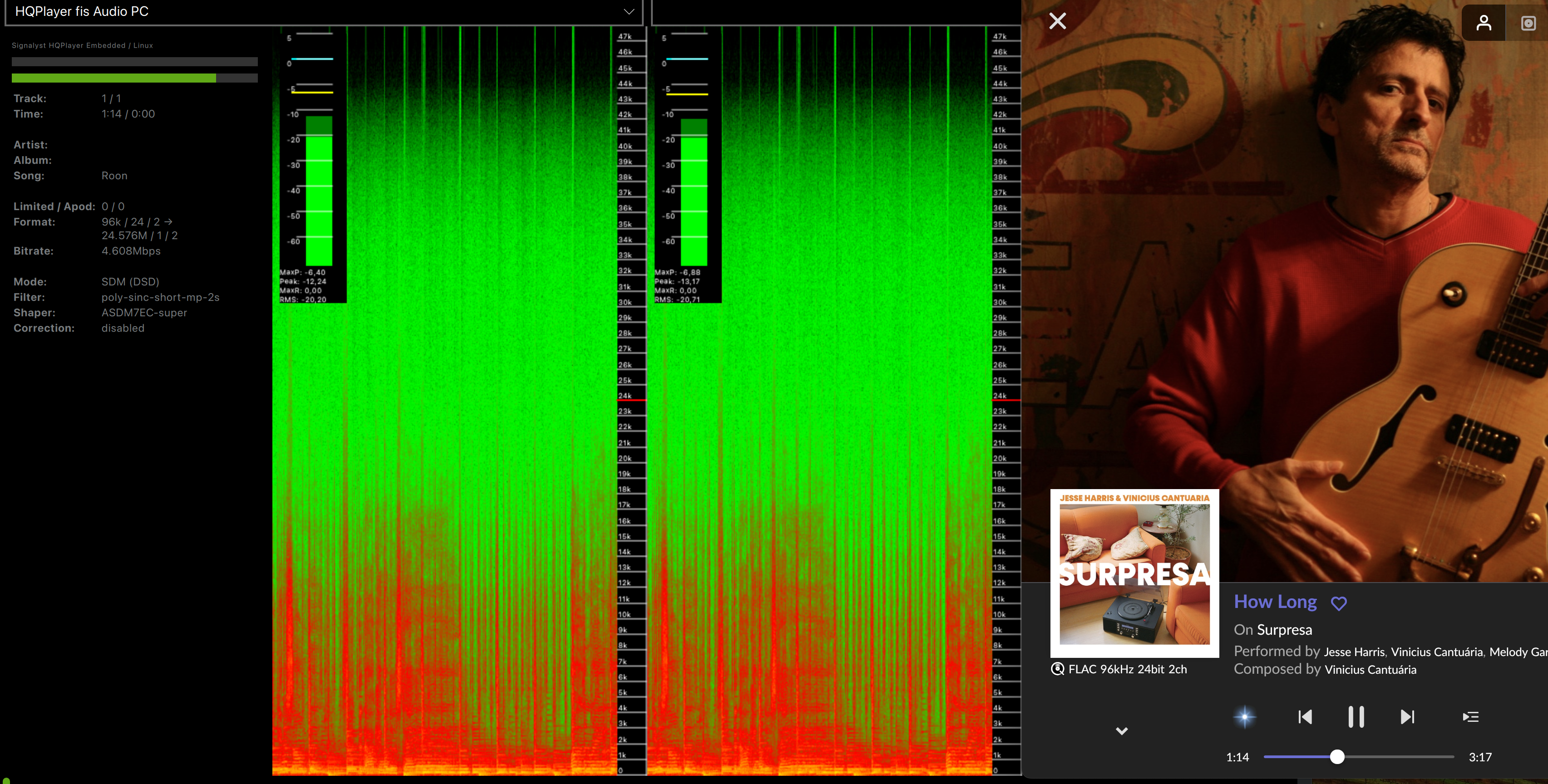

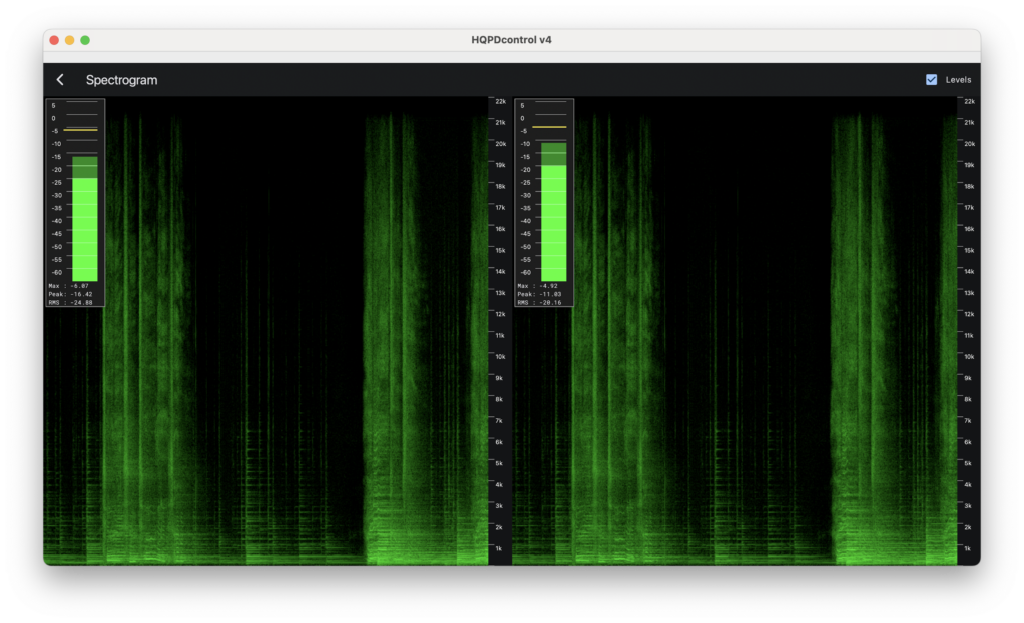

Die Messungen zeigen im ersten Bild unten die vom Hostcomputer ausgehenden Geräusche ohne Isolator und im zweiten Bild die Rauschunterdrückung mit einem Intona Isolator.

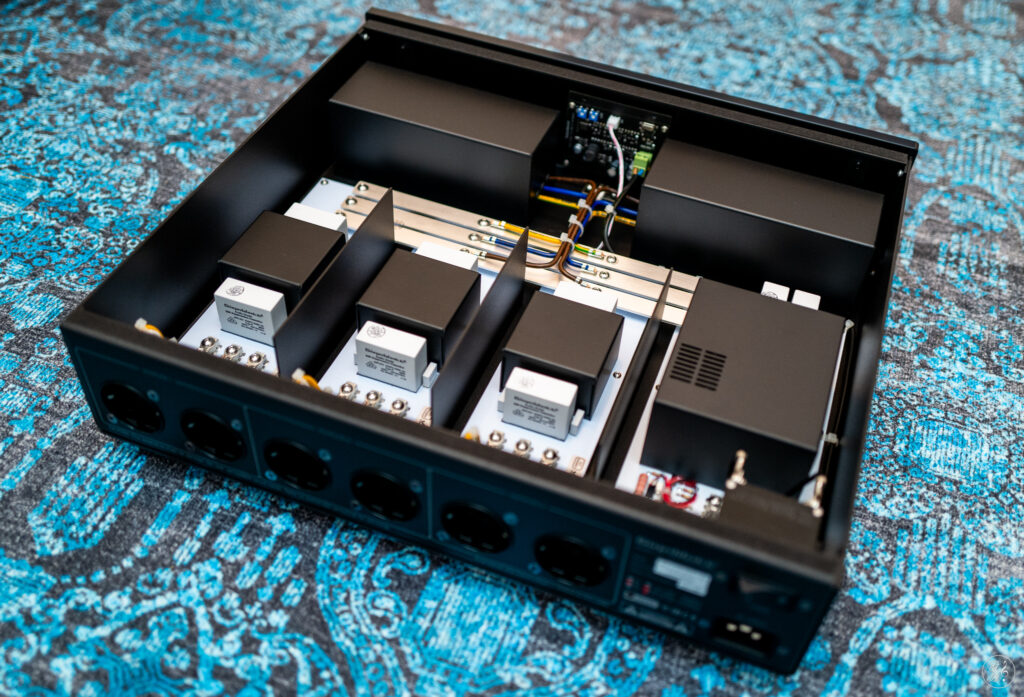

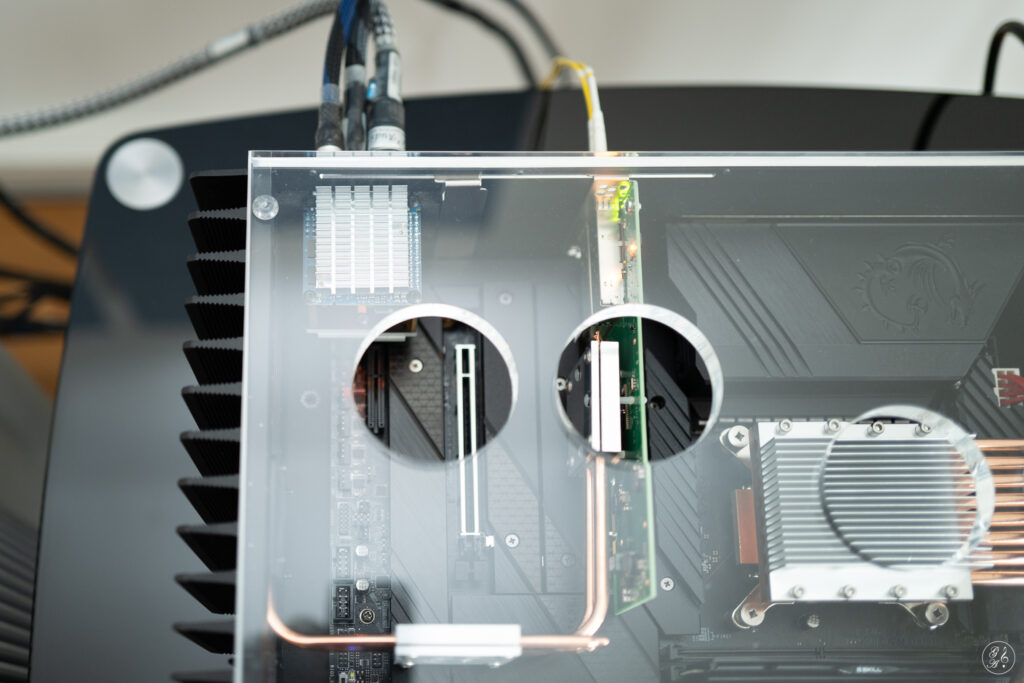

Teardown

Bei technischen Geräten halte ich eine Sicht auf das Innere für wesentlich. Auch ohne technische Ausbildung lassen sich einige Rückschlüsse ziehen. Liegt zum Beispiel ein sauberes Design vor? Sind vorhandene Kabel entsprechend auf die benötigte Länge gekürzt oder liegen sie kreuz und quer im Gehäuse? Sind die Anschlüsse alle sauber verlötet? Nicht ohne Grund liefern wir den fis Audio PC immer mit Acrylglas aus, der den klaren inneren Aufbau zeigt.

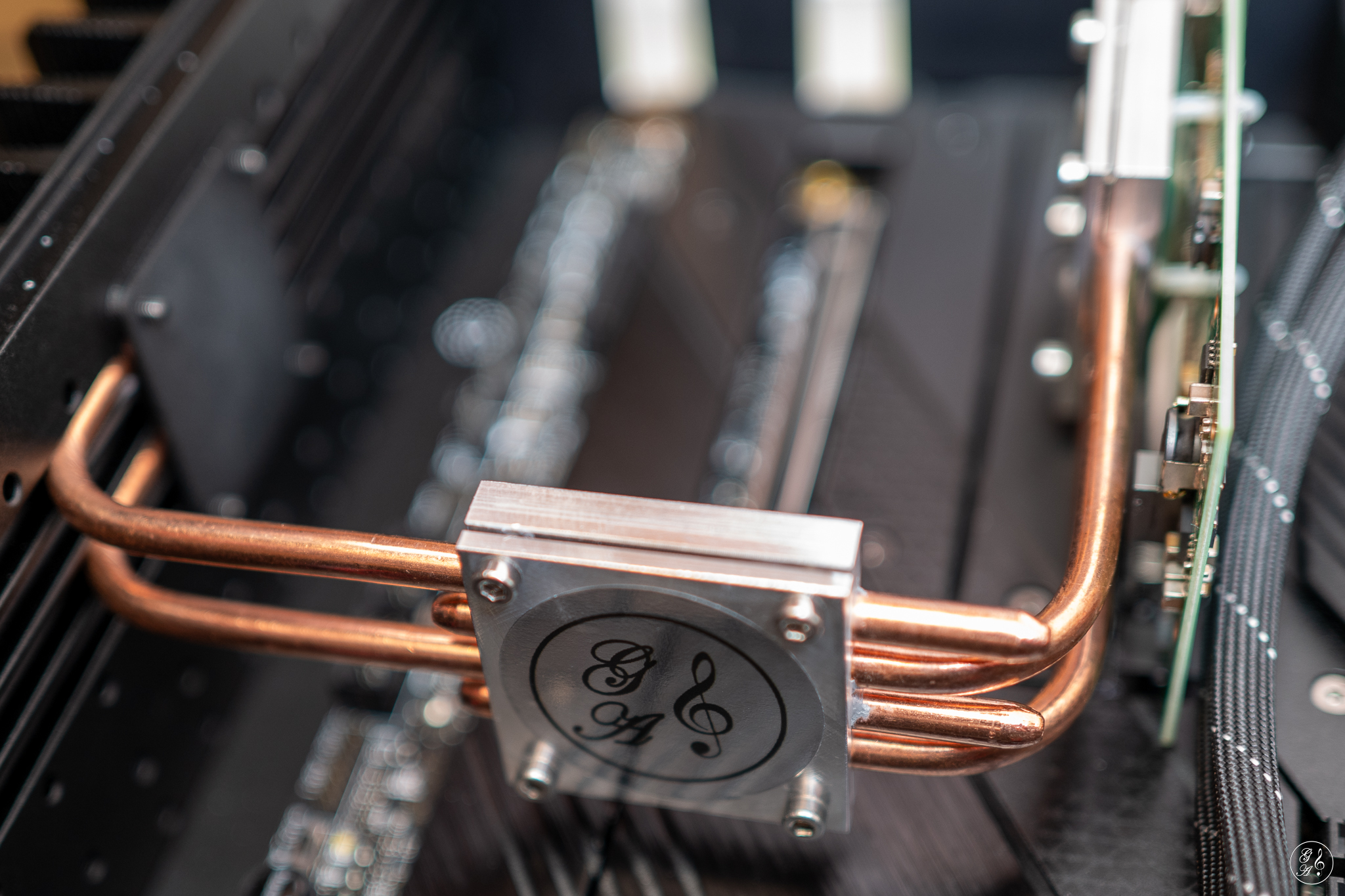

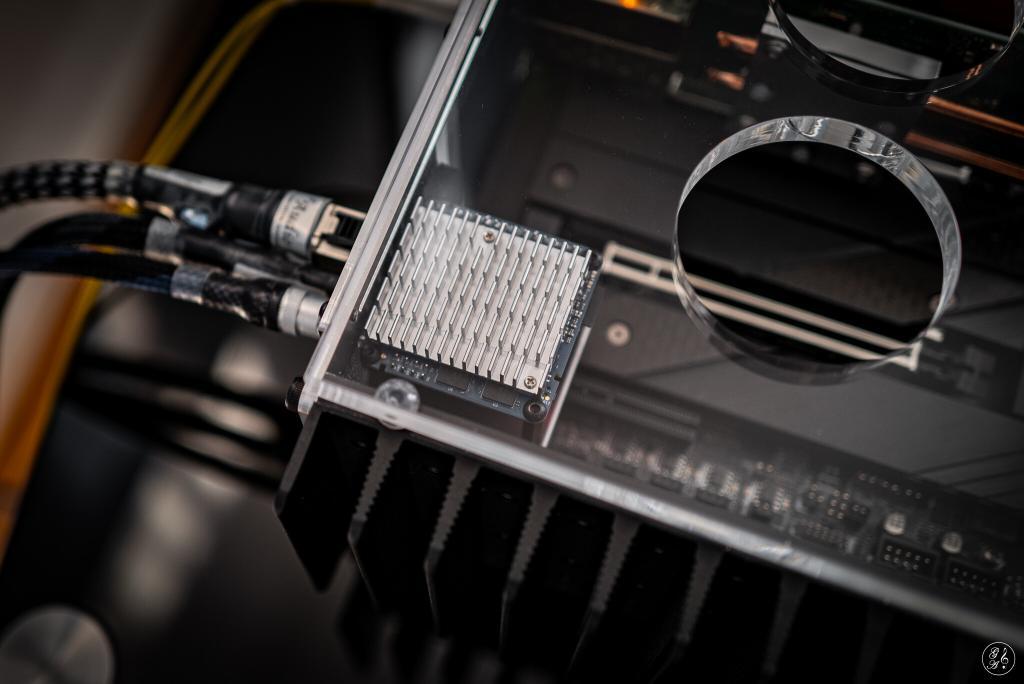

Der USB 3.0 SuperSpeed-Isolator 7055-C von Intona ist ein Musterbeispiel für ein sehr gutes und robustes Industriedesign. Es ist kabellos nach dem Motto: das beste Kabel ist kein Kabel. Im Bild unten ist die Trennung der jeweiligen Platinen für den Eingang (rechts) und den galvanisch isolierten Ausgang (links) zu erkennen. Die Anschlüsse sind sauber verlötet. Alle Bauteile machen einen wertigen Eindruck. Für die Isolation wird unter anderem der hochwertige Coilcraft Power Transformer DA2303-AL verwendet. Bauteile von Coilcraft findest du zum Beispiel auch im Taiko Audio DC DC-ATX.

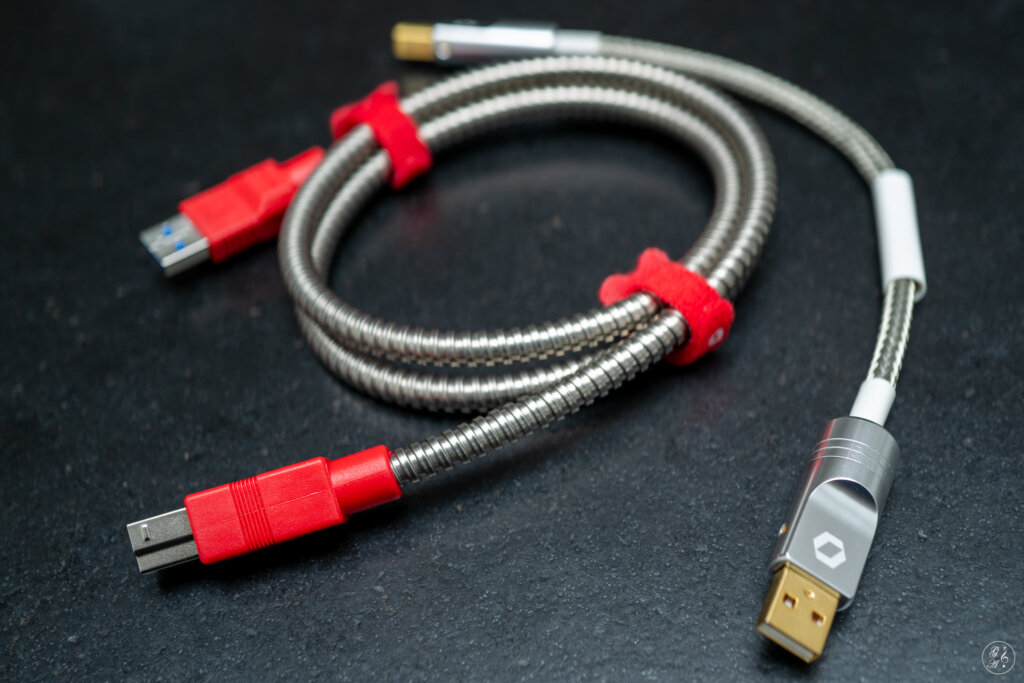

Intona USB Kabel

Für den Test habe ich mir USB-Kabel von Intona besorgt.

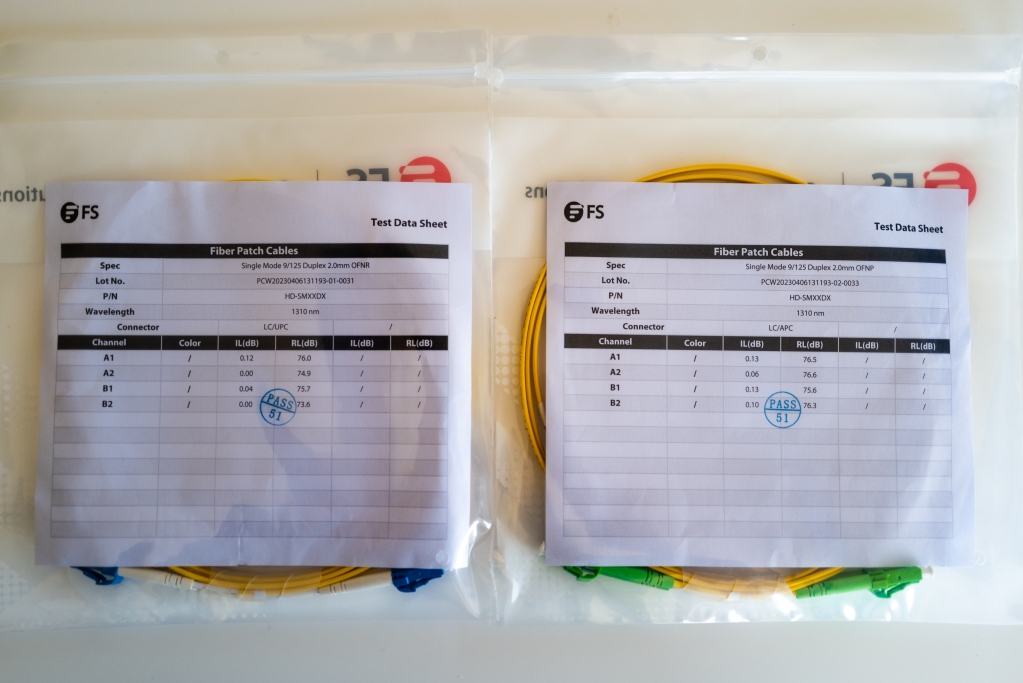

Intona USB 3.0 SuperSpeed-Kabel 4053-X

Das industrielle USB 3.0 SuperSpeed-Kabel 4053-X hat einen Typ-A-Anschluss für den Audio-PC und einen USB 3.x B-Typ-Anschluss für die Verbindung zum Isolator. USB 3 B-Typ-Anschlüsse gelten als besonders robust und dieser Stecker rastet sauber in den Intona Isolator ein.

Technische Merkmale vom Hersteller:

- Maximale Sicherheit zur Vermeidung von ESD, RFI und EMI durch Aufbringen von drei Abschirmschichten

- Innere Abschirmung durch dicht verklebte Aluminiumfolie

- Zentrale Abschirmung – geflochtener Draht aus verzinnten Kupferfilamenten

- Äußere Abschirmung aus spiralförmig gewickelter Edelstahlhülse

- Zuverlässige und stabile Stromversorgungskabel für jedes externe Gerät

- Stärkere Stromleitungen im Vergleich zu anderen Kabeln

- Vergoldete Steckverbinder

- Außenhülle aus Edelstahl

- Individuell getestet

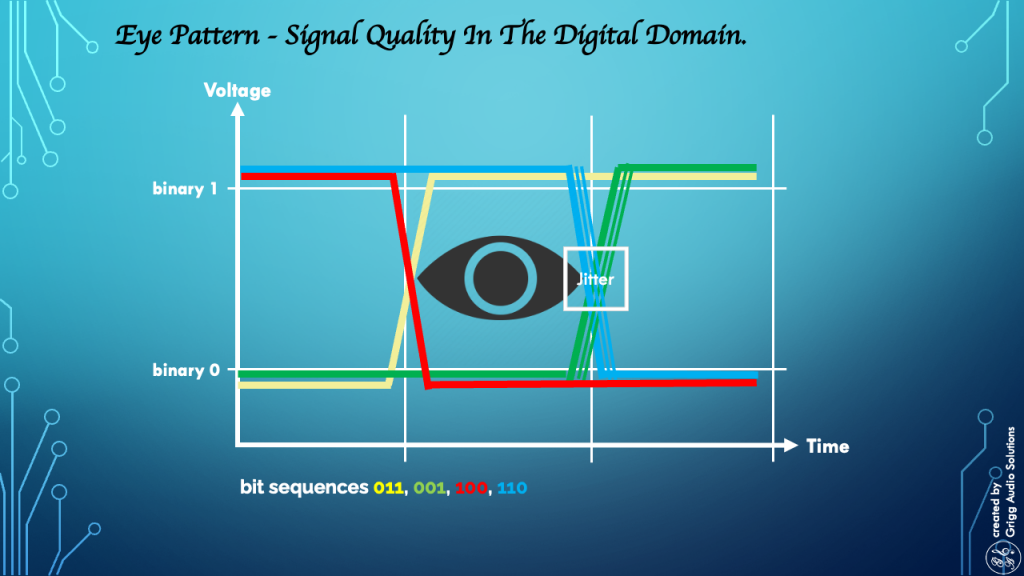

Intona USB 2.0 Hi-Speed-Kabel 4053

Die Verbindung zwischen dem Isolator und dem DAC habe ich mit dem besonders hochwertigen und kurzen 0,2m USB 2.0 Hi-Speed-Kabel 4053 realisiert. Je kürzer die Verbindung zum DAC ist, desto störungsfreier bleibt die Leitung. Mit diesem Kabel legt Intona Wert auf die Impedanzkontinuität über die gesamte Kabellänge für eine höchstmögliche Signaltreue. Überall dort, wo sich die Impedanz ändert, wird Energie reflektiert. Wenn diese zurückkehrenden Energiereflexionen auf andere Unvollkommenheiten treffen, wird ein Teil des Signals in die ursprüngliche Richtung zurückkehren und mehrere Echos erzeugen. Diese Echos erreichen den Empfänger in unterschiedlichen Zeitabständen und machen es für den Empfänger sehr schwierig, die Datenwerte im Signal fehlerfrei zu erkennen.

Technische Merkmale vom Hersteller:

- Maximale Sicherheit zur Vermeidung von ESD, RFI und EMI durch Aufbringen von 2 Abschirmschichten

- Innere Abschirmung durch ein synthetisches / metallisches Laminat plus Geflecht

- Zusätzliche äußere Abschirmung – geflochtener Draht aus verzinnten Kupferfilamenten

- Viel stärkere Stromleitungen im Vergleich zu anderen Kabeln

- Leiter aus sauerstofffreiem Kupfer (OFC) für beste Leitfähigkeit

- 24 Karat vergoldete Steckverbinder

- Nullwiderstand und hochleitfähiger Materialanspruch für die Stecker

- CNC-gefräste Steckergehäuse aus massivem Vollaluminium

- Zwischen-Kabelhülse aus Polyurethan bietet eine extrem hohe Stabilität und verhindert ein Einknicken

- Außenhülle aus ultrafeinem verzinntem Kupfer

- Individuelle Messung des Kabels mit einem Vector Network Analyzer

Klangeindruck

Der T+A DAC 200 nutzt Digital Isolators von Silicon Labs zur galvanischen Trennung der Analogsektion vom Digitalteil. Entsprechend gering war meine Erwartungshaltung an die Wirksamkeit des USB 3.0 SuperSpeed-Isolator 7055-C von Intona. Allerdings gab es schon einen ersten Hinweis vom Entwickler des HQPlayers Jussi Laako:

Mit dem T+A DAC 200 verwende ich Intona 7054 und es macht eine messbare Verbesserung. Und mit dem T+A HA 200 verwende ich den 7055-C und auch dort macht er eine messbare Verbesserung. Darüber hinaus verwende ich mit dem Accuphase DAC-60 Intona 7054 und es macht auch dort eine große messbare Verbesserung. Bei Marantz SA-12SE verwende ich auch 7054, aber dort ist der Unterschied kleiner, aber immer noch wert.

Quelle: https://community.roonlabs.com/t/best-native-dsd-dacs-for-use-with-hqplayer/132298/2214

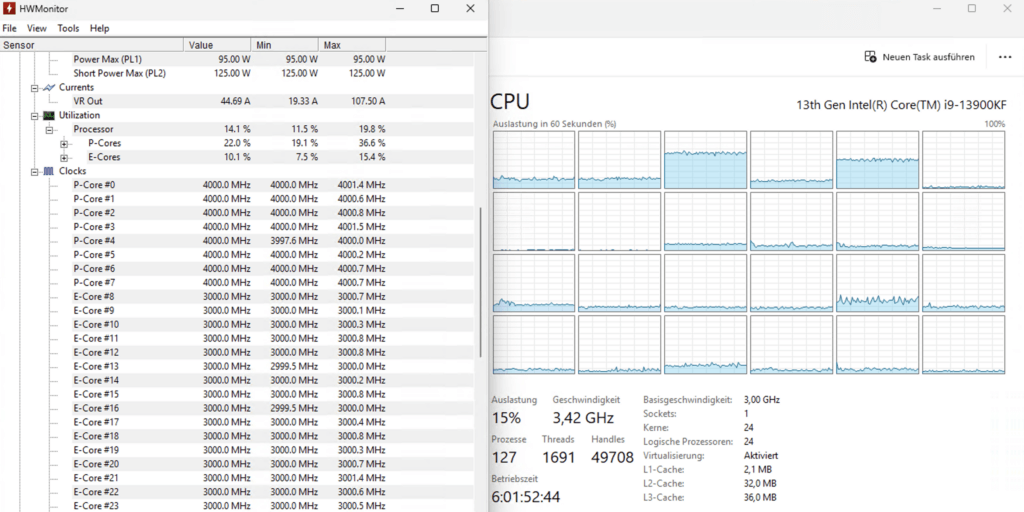

Test mit USB-Anschluss am Motherboard

Die USB-Anschlüsse auf dem MSI MEG Z690 UNIFY sind nicht für Audio optimiert. Dementsprechend bescheiden hört es sich ohne Isolator an. Mit dem Isolator ist die Klangverbesserung substanziell. Der Bass geht tiefer und ist vielschichtiger, die Bühne öffnet sich und insgesamt wirkt das Klangbild homogener. Stimmen verlieren jegliche Schärfe.

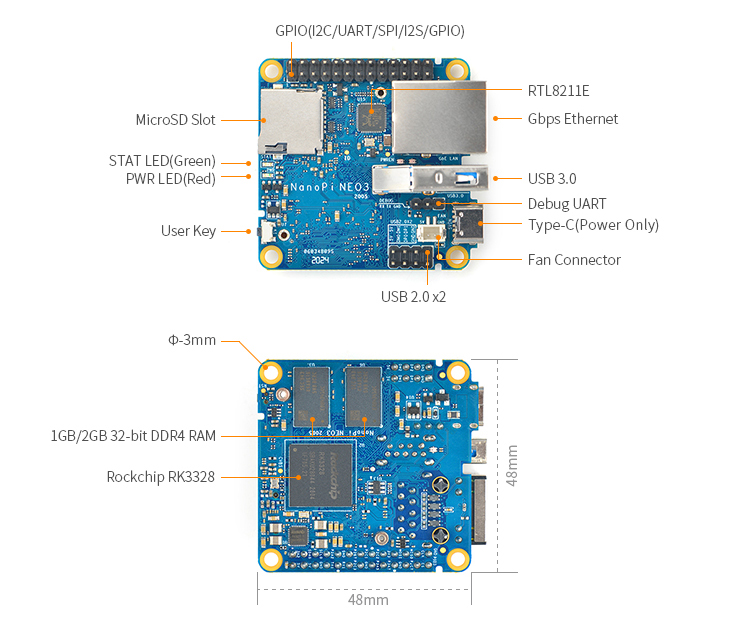

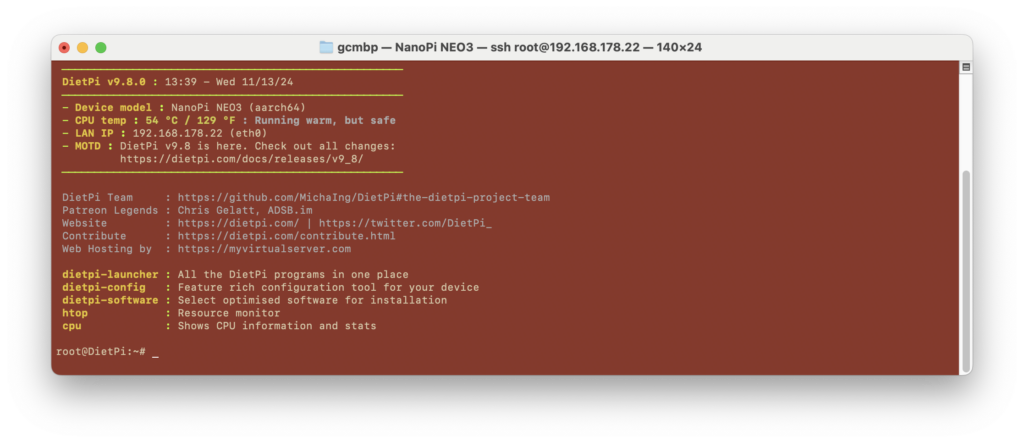

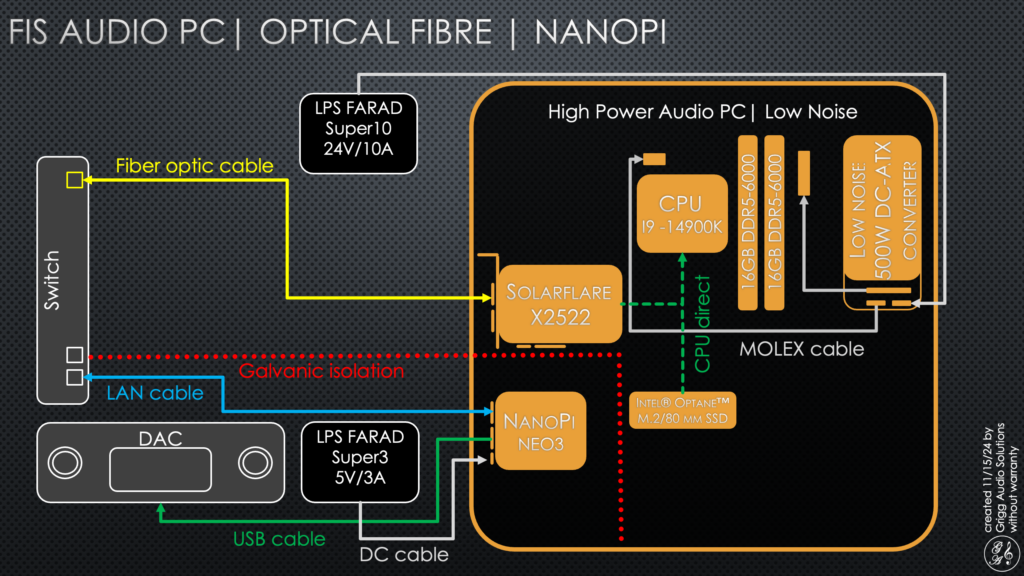

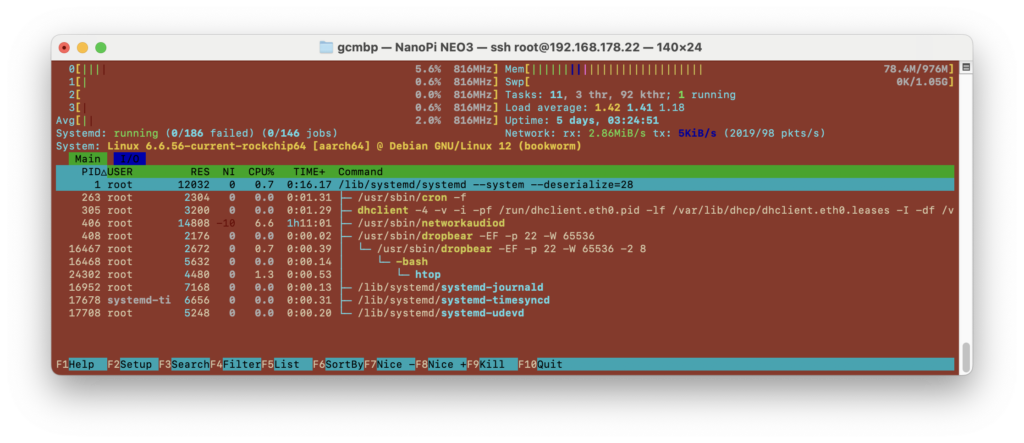

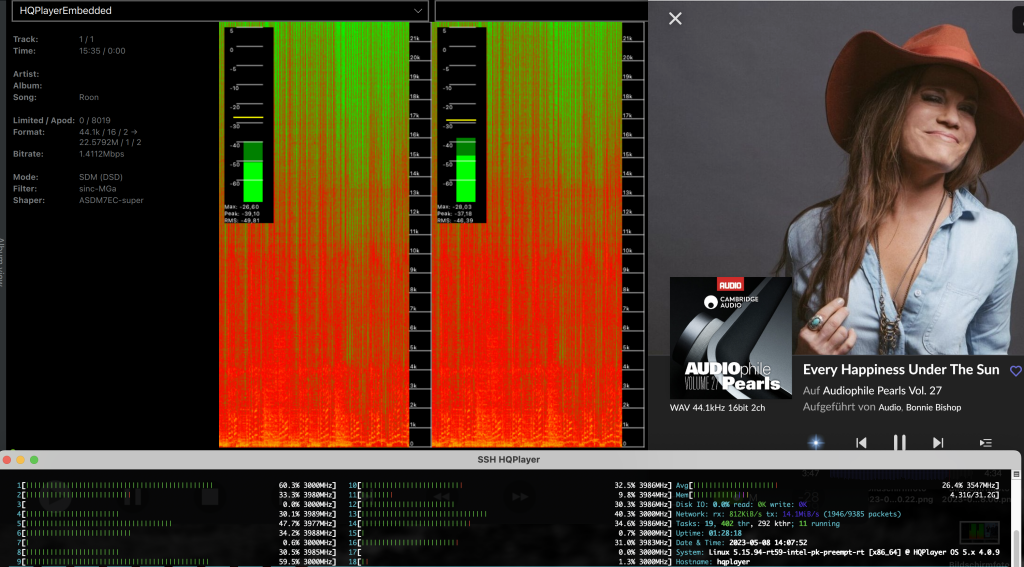

Test mit HQPlayer NAA über NanoPi NEO3

Der Sender ist bei mir ein NanoPi NEO3 mit dem rauscharmen linearen Netzteil FARAD Super3, siehe Newsletter: fis Audio PC mit isolierten NanoPi NEO3 als rauscharmen Endpunkt. Diese Verbindung bringt bereits eine ganz andere Klangqualität, als USB über das Motherboard.

Wird diese Verbindung mit dem Intona Isolator ergänzt, ergibt sich eine ganz neue Plastizität und Raumfüllung der Musik. Eine noch bessere Instrumententrennung. Die Veränderung ist zwar nicht so drastisch, wie bei USB über das Motherboard und Isolator, aber in jedem Fall sofort hörbar.

Wenn ich rein subjektiv den Klang mit Prozentzahlen bewerte, ergibt sich folgendes Bild:

- USB Motherboard = 100% (Ausgangswert)

- USB Motherboard + Intona Isolator = 150%

- USB NanoPi NEO3 = 170%

- USB NanoPi NEO3 + Intona Isolator = 200%

Zusammenfassung

Bei USB (Universal Serial Bus) handelt es sich um eine isochrone Audiodatenübertragung. USB sendet dabei Datenpakete in einem Intervall von 125 Mikrosekunden, was einer Übertragungsrate von 8 kHz entspricht. Die Taktung gibt der DAC vor. Die Daten mit Bit0 und Bit1 werden elektrisch über verschiedene Spannungszustände abgebildet. Deshalb gibt es immer Rauschen auf der Leitung und Leckströme können sich über die Masseverbindung in die angeschlossenen Geräte einnisten.

Signalstörungen können sich mit Knistern oder Dropouts bemerkbar machen. Diffiziler, da nicht sofort als Störung bemerkbar, sind das Rauschen und die Leckströme, die den analogen Teil des DACs verunreinigen können. Bei dem Isolator geht es in erster Linie um die galvanische Trennung dieser Störungen und nicht um die Bitperfekte Datenübertragung, welche über die Prüfsummenprotokolle sowieso gewährleistet ist.

Intona USB 3.0 SuperSpeed-Isolator 7055-C hat ein klares und robustes Industriedesign mit hochwertigen Bauteilen. Messungen bestätigen die Wirksamkeit des Isolators. Die USB Kabel von Intona sorgen für eine störungsfreie Signalübertragung. Dabei legt Intona großen Wert auf die Abschirmung und die Einhaltung der Impedanz über die gesamte Kabellänge.

Im klanglichen Test werden die Bassqualitäten und die Bühne deutlich verbessert. Die Musik fließt plastischer. Instrumente werden hervorragend getrennt und sind besser lokalisierbar. Stimmen werden ohne Schärfen präsentiert.

Du hast Fragen oder möchtest etwas beitragen? Schreibe uns: Kontaktformular

Oder schreibe per E-Mail an: info@griggaudio.de

Verpasse keinen Newsletter:

Disclaimer

Alle Informationen, die du unter Grigg Audio Solutions findest, wurden nach besten Wissen und Gewissen sorgfältig recherchiert und mit Quellenangaben belegt. Irrtümer sind jedoch nie auszuschließen. Wenn du die Informationen für eigene Nachbauten oder Softwareeinstellungen verwendest, machst du das immer auf eigene Gefahr.

Offenlegung finanzieller Interessen

Grigg Audio Solutions bietet Lösungen für die digitale Musikwiedergabe an. Aufgrund der Vielzahl von Lösungswegen und unterschiedlichen Zielbilder kann nur eine bestimmte Auswahl der Hardware und der Software vorgestellt und besprochen werden. Grigg Audio Solutions ist ein gewinnorientiertes Einzelunternehmen. Auch wenn Grigg Audio Solutions Wert auf eine faire ausgewogene Informationsweitergabe legt, soll jeder Leser aus Transparenzgründen wissen, wo die Berichte finanzielle Interessen berühren können.

Damit du die Berichte besser einschätzen kannst, machen wir dich auf die Marken aufmerksam, mit denen Grigg Audio Solutions in Geschäftsverbindung steht: